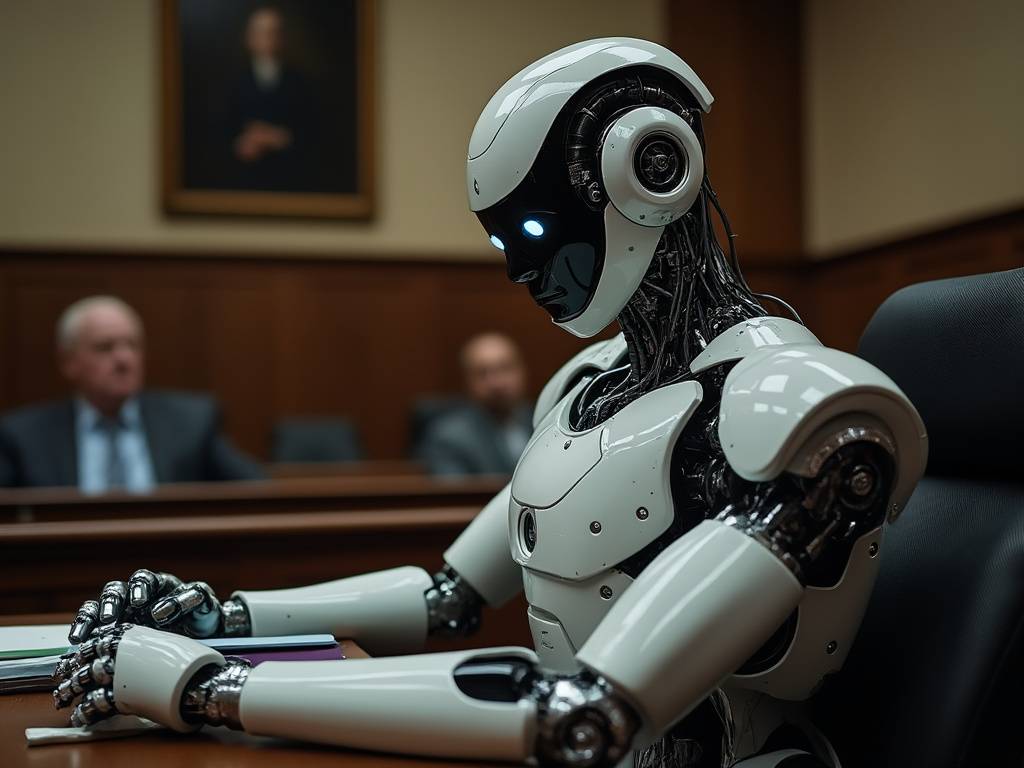

Przełomowy wyrok w sprawie ChatGPT – dlaczego modele językowe nie naruszają praw autorskich?

Niedawno zapadł przełomowy wyrok w sprawie dotyczącej naruszenia praw autorskich przez ChatGPT, który może fundamentalnie zmienić sposób, w jaki postrzegamy kwestie prawne związane z trenowaniem modeli językowych. Raw Story Media, Inc. i AlterNet Media, Inc. pozwały OpenAI, twierdząc, że firma bezprawnie wykorzystała ich treści do trenowania ChatGPT. Jednak sędzia oddaliła sprawę, przedstawiając argumentację, która może wyznaczać nowy kierunek w podobnych sporach.

Klucz do zrozumienia wyroku: modele nie są bazami danych

Fundamentalne znaczenie dla zrozumienia wyroku ma techniczny aspekt funkcjonowania modeli językowych. Jak wyjaśnia Ignacio de Gregorio w szczegółowej analizie sprawy (źródło: medium.com/@ignacio.de.gregorio.noblejas/why-this-chatgpt-court-win-is-historic-997f75927380), modele językowe nie działają jak bazy danych – nie przechowują ani nie kopiują oryginalnych treści, lecz uczą się na podstawie wzorców w danych.

Sędzia w swoim orzeczeniu zwróciła uwagę na kilka kluczowych aspektów:

- Fakty nie podlegają ochronie prawnoautorskiej – model uczy się faktów i wzorców, nie kopiuje treści

- Synteza zamiast kopiowania – odpowiedzi modelu są generowane poprzez syntezę wiedzy z wielu źródeł

- Wielkość zbiorów danych – przy tak ogromnej ilości danych treningowych, wpływ pojedynczego źródła jest znikomy

- Brak konkretnej szkody – powodowie nie byli w stanie udowodnić bezpośrednich szkód wynikających z wykorzystania ich treści

Japoński model jako wzór?

W tym kontekście szczególnie interesujące wydaje się podejście Japonii do kwestii wykorzystania danych w trenowaniu AI. Japońska minister edukacji, sportu, nauki i technologii, Keiko Nagaoka, ogłosiła, że wykorzystanie treści do trenowania modeli AI nie będzie ścigane z tytułu naruszenia praw autorskich. To radykalne podejście, ale ma solidne podstawy techniczne i praktyczne.

Dlaczego modele językowe są inne niż bazy danych?

Kluczowa różnica między bazą danych a modelem językowym polega na tym, że:

- Model nie przechowuje oryginalnych treści

- Nie może odtworzyć dokładnych kopii materiałów treningowych

- Generuje nowe treści na podstawie abstrakcyjnych wzorców

- Wykorzystuje stochastyczne próbkowanie, co oznacza, że nawet przy podobnych zapytaniach generuje różne odpowiedzi

Technologia RAG jako wyjątek

Warto zauważyć, że sytuacja może wyglądać inaczej w przypadku technologii Retrieval-Augmented Generation (RAG), która faktycznie wykorzystuje bazę danych do wspierania generacji tekstu. W tym przypadku można argumentować za stosowaniem bardziej restrykcyjnych zasad dotyczących praw autorskich, ponieważ mamy do czynienia z bezpośrednim przechowywaniem i wykorzystywaniem treści.

Wnioski na przyszłość

Wyrok w sprawie ChatGPT oraz japońskie podejście do praw autorskich w kontekście AI wskazują na potrzebę nowego spojrzenia na prawa autorskie w erze sztucznej inteligencji. Kluczowe wydaje się rozróżnienie między:

- Uczeniem się na danych (podobnie jak człowiek uczy się z dostępnych źródeł)

- Kopiowaniem i przechowywaniem treści (jak w przypadku baz danych)

To rozróżnienie może być fundamentem dla przyszłych regulacji prawnych dotyczących AI, pozwalając na rozwój technologii przy jednoczesnym zachowaniu odpowiedniej ochrony praw twórców w przypadkach, gdy ich treści są faktycznie kopiowane i przechowywane.