Koniec z kompromisami! DFloat11 ratuje dokładność modeli AI, czyli kompresja, na którą czekałem

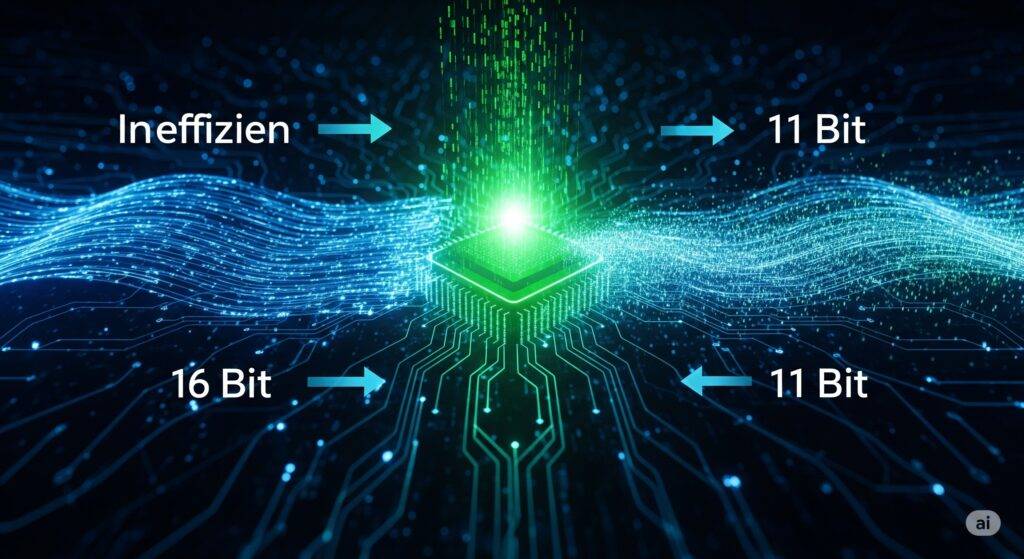

Koniec z kompromisami! DFloat11 ratuje dokładność modeli AI, czyli kompresja, na którą czekałem Od kiedy na dobre zanurzyłem się w świat modeli językowych, jedna rzecz nie dawała mi spokoju. Z jednej strony mamy potężne, ale gigantyczne modele w formacie 16-bitowym (jak BFloat16), które oferują niemal bezstratną jakość, ale wymagają do tego serwerowni i fortuny na …