Następny krok w przetwarzaniu języka naturalnego z architekturą RWKV-v5

Otwierając nowy rozdział w rozwoju sztucznej inteligencji, model językowy Eagle-7B prezentuje się jako przełomowa innowacja, przekraczająca granice dotychczasowych możliwości systemów opartych na transformatorach. Wykorzystując zaawansowaną architekturę RWKV-v5, Eagle-7B, z skalą 7 miliardów parametrów, ustanawia nowe standardy w przetwarzaniu języka naturalnego (NLP), oferując niezrównane możliwości zrozumienia i generowania tekstów w wielu językach, w tym również w języku polskim.

Efektywność i innowacja

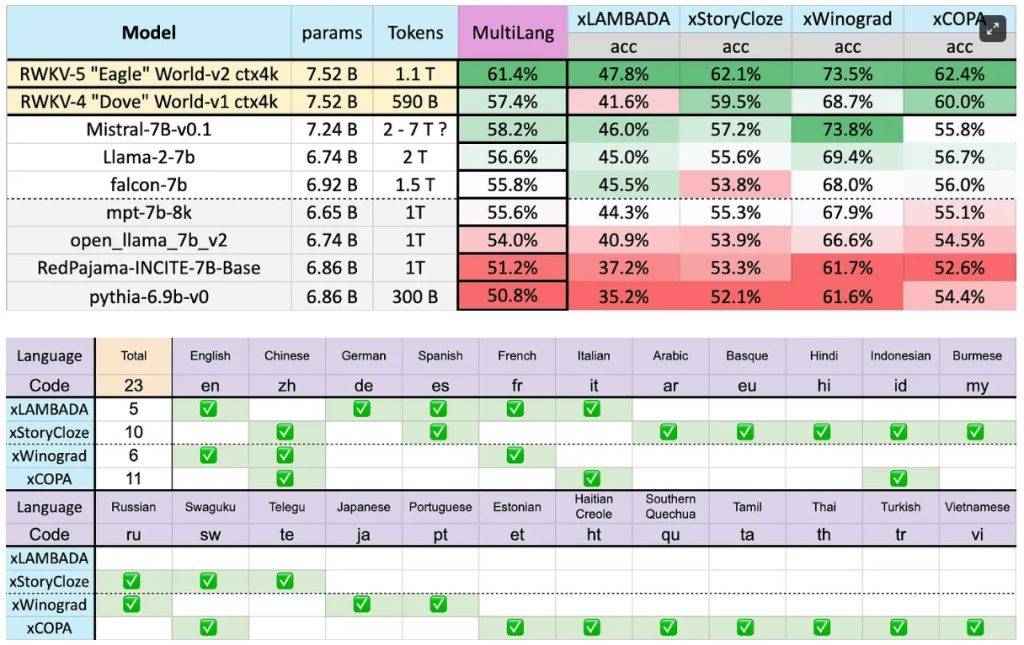

Eagle-7B wyróżnia się nie tylko skalą, ale przede wszystkim innowacyjnym podejściem do budowy i treningu, co pozwala mu osiągnąć wyjątkową efektywność i skuteczność. Dzięki architekturze RWKV-v5, model potrzebuje znacznie mniejszych zasobów do wnioskowania, będąc jednocześnie 10 do 100 razy mniej wymagającym w porównaniu z tradycyjnymi modelami opartymi na transformatorach. Jego zdolność do obsługi długich kontekstów tekstowych otwiera nowe możliwości dla zastosowań NLP, czyniąc go idealnym narzędziem dla zadań wymagających głębokiego zrozumienia i generowania skomplikowanego tekstu.

Bardzo dobry w obsłudze języka polskiego: Nasza analiza

Chociaż Eagle-7B nie został specjalnie testowany dla języka polskiego, nasza analiza wskazuje, że jego zaawansowane możliwości mogą oferować wyjątkową precyzję i zrozumienie tekstu również w tym języku. Jego wszechstronność i zdolność do adaptacji do różnych kontekstów lingwistycznych sprawiają, że jest to jeden z najlepszych dostępnych modeli /tej wielkości/ do przetwarzania języka polskiego na dużą skalę, co robi wrażenie, biorąc pod uwagę ilość obsługiwanych języków. Dane treningowe modelu to 1,1 biliona tokenów w ponad 100 językach!

Przyszłość NLP z Eagle-7B

Dalszy rozwój i optymalizacja modelu Eagle-7B, z jego zdolnością do obsługi szerokiego spektrum języków, w tym języka polskiego, zwiastują nową erę w dziedzinie sztucznej inteligencji. Modele takie jak Eagle-7B potwierdzają, że innowacje w AI mogą przynieść korzyści wszystkim językom, niezależnie od ich globalnego zasięgu, otwierając nowe horyzonty aplikacji i badań w przetwarzaniu języka naturalnego. Jego dostrojenie na pewno jeszcze znacznie poprawi możliwości modelu. Na razie model został dostrojony na bardzo niewielkiej liczbie zadań.

Model można przetestować korzystając z tego linka: https://huggingface.co/spaces/BlinkDL/RWKV-Gradio-2

Pobrać można pobrać pod tym adresem: https://huggingface.co/RWKV/v5-Eagle-7B