Gemma 2B i 7B: Kolejny krok w rozwoju modeli językowych Google

Google, lider w dziedzinie innowacji technologicznych, niedawno ogłosiło wprowadzenie dwóch nowych modeli językowych, Gemma 2B i Gemma 7B, stanowiących znaczący krok naprzód w przetwarzaniu języka naturalnego (NLP). Te modele są otwarte, co oznacza, że badacze, programiści i przedsiębiorstwa mają możliwość eksplorowania ich możliwości i integracji z własnymi projektami, co otwiera nowe horyzonty w rozwoju aplikacji opartych na sztucznej inteligencji.

Przełomowe Modele Językowe Otwarte dla Wszystkich

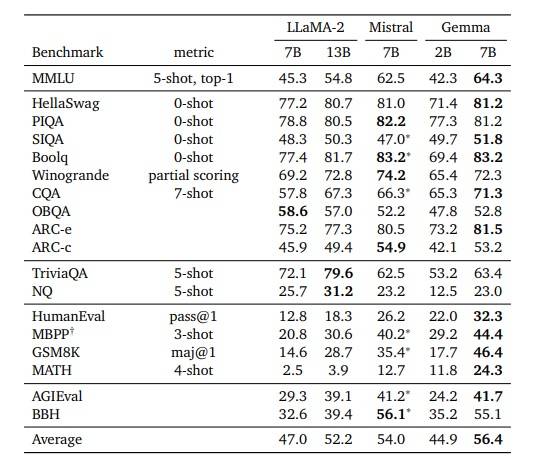

Modele Gemma 2B i 7B zostały opracowane z myślą o zapewnieniu większej precyzji, zrozumienia kontekstu oraz efektywności w generowaniu tekstów. Google, udostępniając te modele jako otwarte, podkreśla swoje zaangażowanie w demokratyzację dostępu do najnowszych technologii AI. Dzięki tej strategii, modele te mają potencjał, by przyczynić się do szybkiego rozwoju innowacyjnych rozwiązań w różnych sektorach – od edukacji po zdrowie i biznes.

na ogólnych danych tekstowych w języku angielskim. źródło: https://storage.googleapis.com/deepmind-media/gemma/gemma-report.pdf

Gemma 7B: Więcej niż Standardowy Model „7B”

Szczególną uwagę przyciąga model Gemma 7B, który, mimo oficjalnej klasyfikacji jako „7B”, wykracza poza standardowe ramy. Z 8,54 miliarda parametrów, Gemma 7B wyraźnie przewyższa inne popularne modele „7B”, takie jak Lama 2 (6,74B) czy Mistral (7,24B), stając się nie tylko potężniejszym narzędziem w przetwarzaniu języka, ale i wskazując na nowy trend w klasyfikacji modeli językowych.

Architektura i Innowacje

Gemma 7B charakteryzuje się nie tylko imponującą liczbą parametrów, ale również zaawansowanymi funkcjami, takimi jak obsługa do 8 tys. tokenów, co pozwala na efektywne przetwarzanie dłuższych tekstów. Wykorzystanie funkcji obsługi wielu zapytań i osadzenie RoPE zapewnia wydajne skalowanie, a kompatybilność z FlashAttention-2 umożliwia szybsze i dokładniejsze przetwarzanie danych.

Co więcej, Gemma 7B wyróżnia się ogromnym słownictwem, zawierającym 256 tys. wpisów – największym wśród ostatnio obserwowanych modeli generatywnych LLM. To słownictwo, ośmiokrotnie większe niż Lama 2 i 1,7 raza większe niż Qwen-1.5, sugeruje, że model został przeszkolony z myślą o zastosowaniach wielojęzycznych, mimo że Google podkreśla jego główne szkolenie w kontekście zadań anglojęzycznych.

Przyszłość Przetwarzania Języka Naturalnego

Chociaż Gemma nie jest modelem multimodalnym ani nie została zaprojektowana do osiągania najnowocześniejszej wydajności w zadaniach wielojęzycznych, jej potencjał jest ogromny. Bogate słownictwo i zaawansowane funkcje techniczne sugerują, że dostosowanie Gemmy do zadań wielojęzycznych może zapewnić znakomitą wydajność, co stanowi ważny krok naprzód w kierunku bardziej zintegrowanej i uniwersalnej komunikacji międzykulturowej.

Wprowadzenie modeli Gemma 2B i 7B przez Google to nie tylko technologiczny przełom, ale również zaproszenie dla globalnej społeczności naukowej i biznesowej do współpracy i eksploracji nowych możliwości, jakie niesie za sobą era zaawansowanego przetwarzania języka naturalnego.